Ollama 사용법

Ollama 설명에 대한 내용입니다.

사용방법

- 모델 실행하기

ollama run 명령어로 원하는 모델을 실행할 수 있습니다. 예를 들어 Llama 3 모델을 실행하려면:

ollama run llama3

만약 해당 모델이 설치되어 있지 않다면 자동으로 다운로드 후 실행됩니다.

- 대화하기

모델이 실행되면 프롬프트가 나타납니다. 여기에 질문을 입력하면 모델이 답변을 생성합니다.

>>> 하늘은 왜 파란가요? 하늘이 파랗게 보이는 이유는 빛의 산란 때문입니다. 태양 빛 중 파장이 짧은 푸른색 계열의 빛이 대기 중 입자에 의해 강하게 산란되어 우리 눈에 많이 들어오기 때문이죠. 반면 파장이 긴 빨간색 계열은 대기를 통과해 직진하는 경향이 있습니다. 이런 레일리 산란 현상 때문에 하늘은 푸르게 보이는 것입니다.

- 멀티라인 입력

긴 문장을 입력하고 싶다면 """ 로 감싸면 됩니다.

>>> """ 안녕하세요. 오늘도 좋은 하루 되세요! """

- 이미지 입력

일부 멀티모달 모델은 이미지 입력도 지원합니다.

>>> 이 이미지에 무엇이 있나요? /path/to/image.png 이미지에는 푸른 하늘을 배경으로 한 해바라기 꽃이 클로즈업되어 있습니다. 노란 꽃잎이 선명하게 보이고, 가운데 꽃술도 잘 보이네요. 매우 생동감 있는 사진입니다.

- 명시적 사용

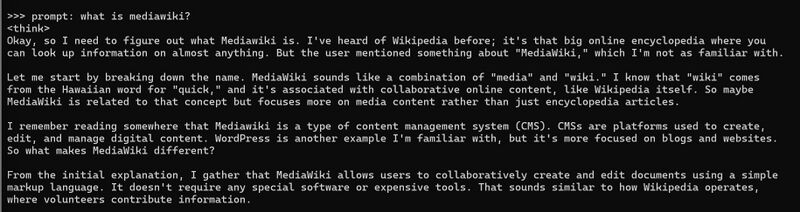

prompt: 라고 명시적 단어를 사용하여 입력 가능하다.

프롬프트 입력 명령 예 - DeepSeek R1

- 모델 커스터마이징

Ollama 라이브러리의 모델은 프롬프트로 커스터마이징할 수 있습니다. 예를 들어 llama3 모델을 수정하려면:

1. 모델 다운로드

ollama pull llama3

2. Modelfile 생성

FROM llama3 # 온도 설정 (높을수록 창의적, 낮을수록 정확함) PARAMETER temperature 1 # 시스템 메시지 설정 SYSTEM """ 당신은 슈퍼마리오입니다. 마리오처럼 대답해주세요. """

3. 모델 생성 및 실행

ollama create mario -f ./Modelfile ollama run mario

- API로 접근

Ollama는 모델 실행과 관리를 위한 REST API도 제공합니다.

응답 생성

curl http://localhost:11434/api/generate -d '{

"model": "llama3",

"prompt": "하늘은 왜 파란가요?"

}'

채팅

curl http://localhost:11434/api/chat -d '{

"model": "llama3",

"messages": [

{"role": "user", "content": "하늘은 왜 파란가요?"}

]

}'

Web ui 사용

Web UI로 활용되는 것은 2가지가 있다.

OPEN WebUI - 오픈소스 Chatbox AI - 유로, 일부 프리플랜

Open Webui

DeepSeek R1을 로컬에 설치한 후 웹으로 활용하는 방법은 다음과 같습니다:

- Open WebUI 사용

Open WebUI는 Ollama와 같은 로컬 LLM 러너를 지원하는 사용자 친화적인 웹 인터페이스입니다.

Open WebUI 설치:

bash pip install open-webui

Open WebUI 실행:

bash open-webui serve

웹 브라우저에서 http://localhost:8080으로 접속

- Docker를 이용한 Open WebUI 설치

Docker를 사용하여 Open WebUI를 더 쉽게 설정할 수 있습니다:

bash docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

설치 후 http://localhost:3000으로 접속하여 사용할 수 있습니다

Chatbox AI 사용

Chatbox AI는 간단한 다운로드로 로컬 LLM과 상호작용할 수 있는 데스크톱 애플리케이션입니다.

Chatbox AI 다운로드 및 설치: https://chatbox.app

설정에서 Ollama를 모델 제공자로 선택

API 호스트를 http://localhost:11434로 설정

모델 드롭다운에서 설치한 DeepSeek R1 모델 선택 (예: deepseek-r1:8b) 이렇게 설정하면 로컬에서 실행 중인 DeepSeek R1과 웹 인터페이스를 통해 상호작용할 수 있습니다

- 주의사항

Open WebUI나 Chatbox AI를 사용하기 전에 Ollama를 통해 DeepSeek R1 모델을 먼저 설치해야 합니다.

로컬 네트워크의 다른 기기에서 접속하려면 호스트 IP 주소를 사용하세요.

보안을 위해 로컬 네트워크 외부에서의 접근은 제한하는 것이 좋습니다.

이러한 방법들을 통해 DeepSeek R1을 로컬에 설치하고 웹 인터페이스를 통해 편리하게 사용할 수 있습니다.

노트북에서 실행 방법

- Ollama 실행 - 파워쉘, 콘솔 모드 가능

- iisreset /stop - 80 포트 점유 끄기

- docker desktop 실행 - open webui 기동 시키기

- Web 접속 가능