비즈니스모델링: 두 판 사이의 차이

172.18.0.1 (토론) 편집 요약 없음 |

|||

| (사용자 2명의 중간 판 5개는 보이지 않습니다) | |||

| 118번째 줄: | 118번째 줄: | ||

실제 SFD 샘플 | 실제 SFD 샘플 | ||

[[파일:sfd_01.jpg]] | [[파일:sfd_01.jpg|500px]] | ||

```mermaid | ```mermaid | ||

| 149번째 줄: | 149번째 줄: | ||

다른 실제 사례: | 다른 실제 사례: | ||

[[file:sfd_02.jpg]] | [[file:sfd_02.jpg|600px]] | ||

```mermaid | ```mermaid | ||

| 375번째 줄: | 375번째 줄: | ||

이러한 SFD 모델들은 비즈니스의 동태적 특성을 이해하고 예측하는데 매우 유용한 도구가 됩니다. | 이러한 SFD 모델들은 비즈니스의 동태적 특성을 이해하고 예측하는데 매우 유용한 도구가 됩니다. | ||

==R을 이용한 경영분석== | |||

R을 활용한 비즈니스 분석의 주요 예제를 한글로 설명해드리겠습니다. | |||

```r | |||

# 필요한 라이브러리 불러오기 | |||

library(tidyverse) | |||

library(forecast) | |||

library(ggplot2) | |||

library(lubridate) | |||

# 1. 매출 분석 및 예측 | |||

# 샘플 매출 데이터 생성 | |||

매출_데이터 <- data.frame( | |||

날짜 = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"), | |||

매출액 = runif(365, 1000, 5000) + sin(1:365/30)*1000 | |||

) | |||

# 시계열 분석 | |||

매출_시계열 <- ts(매출_데이터$매출액, frequency = 7) | |||

매출_예측 <- forecast(auto.arima(매출_시계열), h = 30) | |||

# 매출 예측 그래프 | |||

매출_그래프 <- ggplot() + | |||

geom_line(data = 매출_데이터, aes(x = 날짜, y = 매출액)) + | |||

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30), | |||

y = 매출_예측$mean), color = "blue") + | |||

labs(title = "매출 예측", x = "날짜", y = "매출액") | |||

# 2. 고객 세분화 | |||

# 샘플 고객 데이터 생성 | |||

set.seed(123) | |||

고객_데이터 <- data.frame( | |||

고객ID = 1:1000, | |||

최근성 = sample(1:365, 1000, replace = TRUE), | |||

구매빈도 = rpois(1000, 5), | |||

구매금액 = rlnorm(1000, meanlog = 5) | |||

) | |||

# K-means 클러스터링 수행 | |||

군집분석 <- kmeans(scale(고객_데이터[, c("최근성", "구매빈도", "구매금액")]), centers = 4) | |||

고객_데이터$세그먼트 <- as.factor(군집분석$cluster) | |||

# 세그먼트 시각화 | |||

세그먼트_그래프 <- ggplot(고객_데이터, aes(x = 구매빈도, y = 구매금액, color = 세그먼트)) + | |||

geom_point() + | |||

labs(title = "고객 세그먼트", x = "구매 빈도", y = "총 구매액") | |||

# 3. 코호트 분석 | |||

# 샘플 코호트 데이터 생성 | |||

코호트_데이터 <- data.frame( | |||

가입일 = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE), | |||

고객ID = 1:1000, | |||

매출액 = rlnorm(1000, meanlog = 4) | |||

) | |||

# 코호트 지표 계산 | |||

코호트_분석 <- 코호트_데이터 %>% | |||

mutate(코호트 = format(가입일, "%Y-%m")) %>% | |||

group_by(코호트) %>% | |||

summarise( | |||

고객수 = n(), | |||

총매출 = sum(매출액), | |||

평균매출 = mean(매출액) | |||

) | |||

# 4. 이탈 예측 | |||

# 샘플 고객 이탈 데이터 생성 | |||

이탈_데이터 <- data.frame( | |||

고객ID = 1:1000, | |||

고객기간 = sample(1:60, 1000, replace = TRUE), | |||

월이용료 = runif(1000, 30, 100), | |||

총이용금액 = runif(1000, 1000, 5000), | |||

이탈여부 = sample(c("이탈", "유지"), 1000, replace = TRUE, prob = c(0.2, 0.8)) | |||

) | |||

# 로지스틱 회귀 모델 적용 | |||

이탈_모델 <- glm(이탈여부 ~ 고객기간 + 월이용료 + 총이용금액, | |||

data = 이탈_데이터, | |||

family = "binomial") | |||

# 비즈니스 리포트 생성 함수 | |||

비즈니스_리포트_생성 <- function(데이터) { | |||

요약_통계 <- list( | |||

총고객수 = nrow(데이터), | |||

평균매출 = mean(데이터$총이용금액), | |||

이탈율 = mean(데이터$이탈여부 == "이탈"), | |||

우수고객수 = sum(데이터$총이용금액 > mean(데이터$총이용금액)) | |||

) | |||

return(요약_통계) | |||

} | |||

# 데이터 시각화 함수 | |||

비즈니스_대시보드_생성 <- function(데이터) { | |||

# 매출 트렌드 | |||

매출_그래프 <- ggplot(데이터, aes(x = 고객기간, y = 총이용금액)) + | |||

geom_point() + | |||

geom_smooth() + | |||

labs(title = "고객 기간별 매출 현황") | |||

# 이탈 분포 | |||

이탈_그래프 <- ggplot(데이터, aes(x = 이탈여부, fill = 이탈여부)) + | |||

geom_bar() + | |||

labs(title = "이탈 고객 분포") | |||

return(list(매출_그래프 = 매출_그래프, 이탈_그래프 = 이탈_그래프)) | |||

} | |||

``` | |||

이 R 코드는 다음과 같은 주요 비즈니스 분석 기법을 포함하고 있습니다: | |||

1. 매출 분석 및 예측 | |||

- ARIMA를 이용한 시계열 분석 | |||

- 매출 트렌드 시각화 | |||

- 미래 매출 예측 | |||

2. 고객 세분화 분석 | |||

- K-means 클러스터링 | |||

- RFM(최근성, 구매빈도, 구매금액) 분석 | |||

- 세그먼트 시각화 | |||

3. 코호트 분석 | |||

- 가입 시점별 고객 그룹화 | |||

- 코호트별 매출 지표 | |||

- 고객 유지율 분석 | |||

4. 고객 이탈 예측 | |||

- 로지스틱 회귀 모델링 | |||

- 위험 요인 분석 | |||

- 고객 유지 인사이트 도출 | |||

코드에 포함된 주요 기능: | |||

- 데이터 준비 및 전처리 | |||

- 통계 분석 | |||

- 데이터 시각화 | |||

- 모델 구축 | |||

- 리포트 생성 | |||

<pre> | |||

# 필요한 라이브러리 불러오기 | |||

library(tidyverse) | |||

library(forecast) | |||

library(ggplot2) | |||

library(lubridate) | |||

# 1. 매출 분석 및 예측 | |||

# 샘플 매출 데이터 생성 | |||

매출_데이터 <- data.frame( | |||

날짜 = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"), | |||

매출액 = runif(365, 1000, 5000) + sin(1:365/30)*1000 | |||

) | |||

# 시계열 분석 | |||

매출_시계열 <- ts(매출_데이터$매출액, frequency = 7) | |||

매출_예측 <- forecast(auto.arima(매출_시계열), h = 30) | |||

# 매출 예측 그래프 | |||

매출_그래프 <- ggplot() + | |||

geom_line(data = 매출_데이터, aes(x = 날짜, y = 매출액)) + | |||

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30), | |||

y = 매출_예측$mean), color = "blue") + | |||

labs(title = "매출 예측", x = "날짜", y = "매출액") | |||

# 2. 고객 세분화 | |||

# 샘플 고객 데이터 생성 | |||

set.seed(123) | |||

고객_데이터 <- data.frame( | |||

고객ID = 1:1000, | |||

최근성 = sample(1:365, 1000, replace = TRUE), | |||

구매빈도 = rpois(1000, 5), | |||

구매금액 = rlnorm(1000, meanlog = 5) | |||

) | |||

# K-means 클러스터링 수행 | |||

군집분석 <- kmeans(scale(고객_데이터[, c("최근성", "구매빈도", "구매금액")]), centers = 4) | |||

고객_데이터$세그먼트 <- as.factor(군집분석$cluster) | |||

# 세그먼트 시각화 | |||

세그먼트_그래프 <- ggplot(고객_데이터, aes(x = 구매빈도, y = 구매금액, color = 세그먼트)) + | |||

geom_point() + | |||

labs(title = "고객 세그먼트", x = "구매 빈도", y = "총 구매액") | |||

# 3. 코호트 분석 | |||

# 샘플 코호트 데이터 생성 | |||

코호트_데이터 <- data.frame( | |||

가입일 = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE), | |||

고객ID = 1:1000, | |||

매출액 = rlnorm(1000, meanlog = 4) | |||

) | |||

# 코호트 지표 계산 | |||

코호트_분석 <- 코호트_데이터 %>% | |||

mutate(코호트 = format(가입일, "%Y-%m")) %>% | |||

group_by(코호트) %>% | |||

summarise( | |||

고객수 = n(), | |||

총매출 = sum(매출액), | |||

평균매출 = mean(매출액) | |||

) | |||

# 4. 이탈 예측 | |||

# 샘플 고객 이탈 데이터 생성 | |||

이탈_데이터 <- data.frame( | |||

고객ID = 1:1000, | |||

고객기간 = sample(1:60, 1000, replace = TRUE), | |||

월이용료 = runif(1000, 30, 100), | |||

총이용금액 = runif(1000, 1000, 5000), | |||

이탈여부 = sample(c("이탈", "유지"), 1000, replace = TRUE, prob = c(0.2, 0.8)) | |||

) | |||

# 로지스틱 회귀 모델 적용 | |||

이탈_모델 <- glm(이탈여부 ~ 고객기간 + 월이용료 + 총이용금액, | |||

data = 이탈_데이터, | |||

family = "binomial") | |||

# 비즈니스 리포트 생성 함수 | |||

비즈니스_리포트_생성 <- function(데이터) { | |||

요약_통계 <- list( | |||

총고객수 = nrow(데이터), | |||

평균매출 = mean(데이터$총이용금액), | |||

이탈율 = mean(데이터$이탈여부 == "이탈"), | |||

우수고객수 = sum(데이터$총이용금액 > mean(데이터$총이용금액)) | |||

) | |||

return(요약_통계) | |||

} | |||

# 데이터 시각화 함수 | |||

비즈니스_대시보드_생성 <- function(데이터) { | |||

# 매출 트렌드 | |||

매출_그래프 <- ggplot(데이터, aes(x = 고객기간, y = 총이용금액)) + | |||

geom_point() + | |||

geom_smooth() + | |||

labs(title = "고객 기간별 매출 현황") | |||

# 이탈 분포 | |||

이탈_그래프 <- ggplot(데이터, aes(x = 이탈여부, fill = 이탈여부)) + | |||

geom_bar() + | |||

labs(title = "이탈 고객 분포") | |||

return(list(매출_그래프 = 매출_그래프, 이탈_그래프 = 이탈_그래프)) | |||

} | |||

</pre> | |||

동일 코드 영문 | |||

<pre> | |||

# Load required libraries | |||

library(tidyverse) | |||

library(forecast) | |||

library(ggplot2) | |||

library(lubridate) | |||

# 1. Sales Analysis and Forecasting | |||

# Create sample sales data | |||

sales_data <- data.frame( | |||

date = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"), | |||

sales = runif(365, 1000, 5000) + sin(1:365/30)*1000 | |||

) | |||

# Time series analysis | |||

sales_ts <- ts(sales_data$sales, frequency = 7) | |||

sales_forecast <- forecast(auto.arima(sales_ts), h = 30) | |||

# Plot sales forecast | |||

plot_forecast <- ggplot() + | |||

geom_line(data = sales_data, aes(x = date, y = sales)) + | |||

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30), | |||

y = sales_forecast$mean), color = "blue") + | |||

labs(title = "Sales Forecast", x = "Date", y = "Sales") | |||

# 2. Customer Segmentation | |||

# Create sample customer data | |||

set.seed(123) | |||

customer_data <- data.frame( | |||

customer_id = 1:1000, | |||

recency = sample(1:365, 1000, replace = TRUE), | |||

frequency = rpois(1000, 5), | |||

monetary = rlnorm(1000, meanlog = 5) | |||

) | |||

# Perform k-means clustering | |||

kmeans_result <- kmeans(scale(customer_data[, c("recency", "frequency", "monetary")]), centers = 4) | |||

customer_data$segment <- as.factor(kmeans_result$cluster) | |||

# Visualize segments | |||

segment_plot <- ggplot(customer_data, aes(x = frequency, y = monetary, color = segment)) + | |||

geom_point() + | |||

labs(title = "Customer Segments", x = "Purchase Frequency", y = "Total Spend") | |||

# 3. Cohort Analysis | |||

# Create sample cohort data | |||

cohort_data <- data.frame( | |||

join_date = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE), | |||

customer_id = 1:1000, | |||

revenue = rlnorm(1000, meanlog = 4) | |||

) | |||

# Calculate cohort metrics | |||

cohort_analysis <- cohort_data %>% | |||

mutate(cohort = format(join_date, "%Y-%m")) %>% | |||

group_by(cohort) %>% | |||

summarise( | |||

customers = n(), | |||

total_revenue = sum(revenue), | |||

avg_revenue = mean(revenue) | |||

) | |||

# 4. Market Basket Analysis | |||

library(arules) | |||

# Create sample transaction data | |||

transaction_data <- data.frame( | |||

transaction_id = rep(1:500, each = 3), | |||

product = sample(c("A", "B", "C", "D", "E"), 1500, replace = TRUE) | |||

) | |||

# Convert to transactions format | |||

transactions <- split(transaction_data$product, transaction_data$transaction_id) | |||

transactions <- as(transactions, "transactions") | |||

# Find frequent itemsets | |||

frequent_items <- apriori(transactions, | |||

parameter = list(support = 0.01, confidence = 0.5)) | |||

# 5. Churn Prediction | |||

# Create sample customer churn data | |||

churn_data <- data.frame( | |||

customer_id = 1:1000, | |||

tenure = sample(1:60, 1000, replace = TRUE), | |||

monthly_charges = runif(1000, 30, 100), | |||

total_charges = runif(1000, 1000, 5000), | |||

churn = sample(c("Yes", "No"), 1000, replace = TRUE, prob = c(0.2, 0.8)) | |||

) | |||

# Fit logistic regression model | |||

churn_model <- glm(churn ~ tenure + monthly_charges + total_charges, | |||

data = churn_data, | |||

family = "binomial") | |||

# Function to generate summary report | |||

generate_business_report <- function(data) { | |||

summary_stats <- list( | |||

total_customers = nrow(data), | |||

average_revenue = mean(data$total_charges), | |||

churn_rate = mean(data$churn == "Yes"), | |||

high_value_customers = sum(data$total_charges > mean(data$total_charges)) | |||

) | |||

return(summary_stats) | |||

} | |||

# Example of data visualization function | |||

create_business_dashboard <- function(data) { | |||

# Revenue trend | |||

revenue_plot <- ggplot(data, aes(x = tenure, y = total_charges)) + | |||

geom_point() + | |||

geom_smooth() + | |||

labs(title = "Revenue by Customer Tenure") | |||

# Churn distribution | |||

churn_plot <- ggplot(data, aes(x = churn, fill = churn)) + | |||

geom_bar() + | |||

labs(title = "Churn Distribution") | |||

return(list(revenue_plot = revenue_plot, churn_plot = churn_plot)) | |||

} | |||

</pre> | |||

==기본 사항== | |||

확보할 수 있는 데이터 형태로 분석 방법이 개발된 듯 | |||

기존 참고하고자 하는 데이터 기준, 추가 환경 데이터, 제품 데이터, 판매 데이터 등을 추정하여 만듬 | |||

AI 분석은 요약 데이터를 활용하는 것이 좋으며 (R에서 판매량 데이터를 단순 사인데이터로 만듬) | |||

모든 데이터를 넣어서 처리하는 것은 머신러닝 혹은 빅데이터 처리 프로세스를 그대로 따르는 것이 좋음 | |||

결론: | |||

# 데이터 취득 전략 - 기존 데이터를 변경하거나, 데이터 처리에 있어, 필요한 데이터 기준 선별, 지속 데이터 취득 | |||

# 다른 요소는 이에 맞춰 취합 - 영향을 주는 요소들 경험 및 실제 데이터를 기준으로 반영 (이전 데이터 시점과 해당일 선행 이슈 파악?) | |||

# 해석 방법을 염두에 둔 데이터 모델 추정 | |||

[[분류: AI]] | |||

[[분류: 비즈니스]] | |||

2025년 9월 1일 (월) 02:53 기준 최신판

비즈니스 모델링에 대한 내용입니다.

목적: 비즈니스 환경을 기반으로 미래 예측의 가능성을 확인한다.

비즈니스 예측을 위한 주요 모델링 방법들을 설명해드리겠습니다:

1. 시계열 분석 모델 - ARIMA (AutoRegressive Integrated Moving Average)

- 과거 데이터의 패턴을 기반으로 미래 예측 - 계절성, 추세, 주기성 고려 - 매출, 수요 예측에 적합

- 지수평활법 (Exponential Smoothing)

- Simple Exponential Smoothing (SES) - Holt's Method (추세 고려) - Holt-Winters' Method (계절성 고려) - 단기 예측에 효과적

2. 회귀 분석 모델 - 선형 회귀 (Linear Regression)

- 변수 간의 선형 관계 분석 - 가격 책정, 수요 예측에 활용

- 다중 회귀 (Multiple Regression)

- 여러 독립변수의 영향 분석 - 복잡한 비즈니스 관계 모델링

3. 머신러닝 기반 모델 - Random Forest

- 여러 의사결정 트리의 앙상블 - 고객 이탈 예측, 시장 세분화

- 신경망 (Neural Networks)

- 복잡한 패턴 인식 - 수요 예측, 가격 최적화

4. 시스템 다이내믹스 모델 - 인과순환도 (Causal Loop Diagram)

- 시스템 변수 간 관계 시각화 - 전략적 의사결정 지원

- 저량-유량 다이어그램 (Stock and Flow Diagram)

- 시스템의 동태적 행태 분석 - 자원 할당, 공급망 관리

5. 확률 모델 - 몬테카를로 시뮬레이션

- 불확실성을 고려한 시나리오 분석 - 리스크 평가, 포트폴리오 최적화

- 마르코프 체인

- 상태 전이 확률 기반 예측 - 고객 행동 예측, 시장 점유율 분석

6. 최적화 모델 - 선형 계획법 (Linear Programming)

- 제약 조건 하의 최적해 도출 - 자원 할당, 생산 계획

- 정수 계획법 (Integer Programming)

- 이산적 의사결정 문제 해결 - 설비 투자, 입지 선정

각 모델의 선택 기준:

1. 데이터 특성 - 데이터의 양과 질 - 시계열성 여부 - 변수 간 관계

2. 예측 목적 - 단기/중기/장기 예측 - 정확도 요구 수준 - 설명력 필요 정도

3. 실무 제약 - 데이터 가용성 - 계산 복잡도 - 구현 용이성

4. 비즈니스 상황 - 산업 특성 - 시장 환경 - 의사결정 시급성

모델 활용 시 고려사항: 1. 데이터 전처리의 중요성 2. 모델 가정의 현실성 검증 3. 정기적인 모델 성능 평가 4. 비즈니스 통찰과의 연계 5. 예측 결과의 실무 활용 방안

이러한 다양한 모델링 방법들을 비즈니스 상황과 목적에 맞게 선택하고 조합하여 사용하는 것이 효과적입니다.

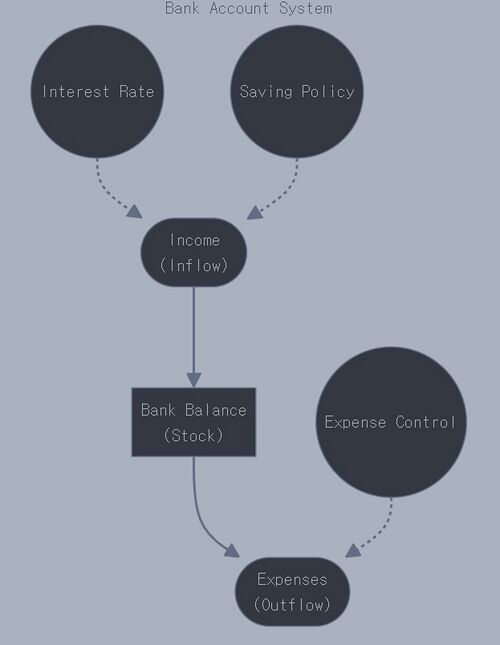

Stock & Flow Diagram(SFD)은 시스템 다이내믹스에서 사용되는 중요한 모델링 도구입니다. 시스템의 구조와 동태적 행태를 시각화하는데 사용됩니다.

주요 구성요소: 1. Stock(저량): 시스템 내에서 축적되는 요소

- 예: 은행 잔고, 재고, 인구, 지식 수준 - 사각형으로 표시

2. Flow(유량): Stock의 증감을 나타내는 요소

- 예: 수입/지출, 생산/판매, 출생/사망 - 파이프 모양의 화살표로 표시

3. Converter(변환기): 시스템에 영향을 미치는 외부 변수

- 예: 이자율, 생산성, 출생률 - 원으로 표시

4. Connector(연결자): 요소들 간의 인과관계

- 일반 화살표로 표시

실제 SFD 샘플

```mermaid flowchart LR

subgraph "Bank Account System"

B["Bank Balance

(Stock)"]

I(["Income

(Inflow)"])

E(["Expenses

(Outflow)"])

IR((Interest Rate))

SP((Saving Policy))

EC((Expense Control))

I --> B

B --> E

IR -.-> I

SP -.-> I

EC -.-> E

end

```

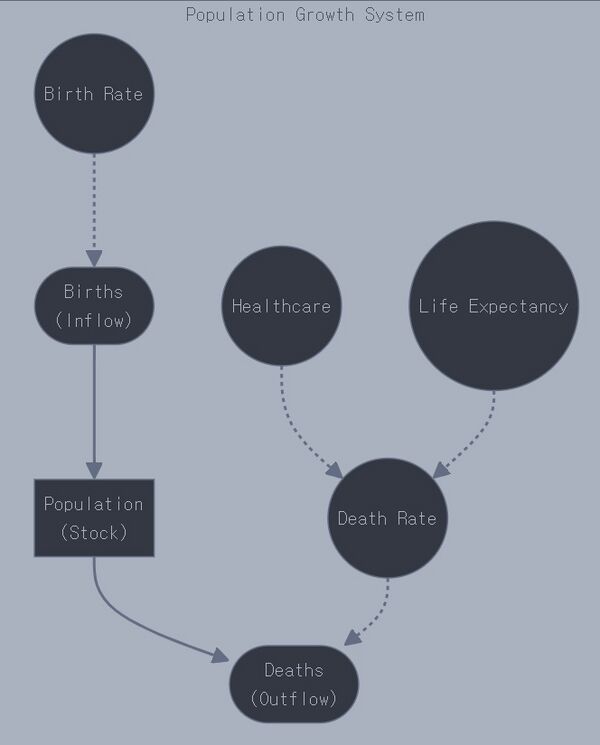

다른 실제 사례:

```mermaid flowchart LR

subgraph "Population Growth System"

P["Population

(Stock)"]

B(["Births

(Inflow)"])

D(["Deaths

(Outflow)"])

BR((Birth Rate))

DR((Death Rate))

HC((Healthcare))

LE((Life Expectancy))

B --> P

P --> D

BR -.-> B

DR -.-> D

HC -.-> DR

LE -.-> DR

end

```

SFD의 실제 활용 분야: 1. 비즈니스 관리

- 재고 관리 시스템 - 고객 관계 관리 - 재무 흐름 분석

2. 환경 시스템

- 생태계 모델링 - 오염 확산 분석 - 자원 순환 시스템

3. 사회 시스템

- 도시 성장 모델 - 전염병 확산 모델 - 인구 동태 분석

4. 프로젝트 관리

- 리소스 할당 - 작업 진행 상황 - 예산 관리

이러한 SFD를 통해 복잡한 시스템의 동태적 행태를 이해하고 예측할 수 있으며, 정책이나 의사결정의 영향을 시뮬레이션할 수 있습니다.

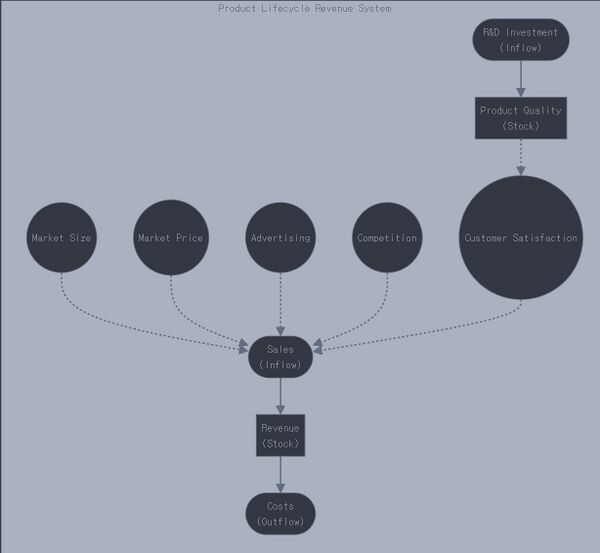

SFD를 활용한 몇 가지 대표적인 비즈니스 예측 모델입니다.

1. 제품 수명주기 및 매출 예측 모델:

```mermaid flowchart LR

subgraph "Product Lifecycle Revenue System"

R["Revenue

(Stock)"]

S(["Sales

(Inflow)"])

C(["Costs

(Outflow)"])

MS((Market Size))

MP((Market Price))

AD((Advertising))

CP((Competition))

PQ["Product Quality

(Stock)"]

RD(["R&D Investment

(Inflow)"])

CS((Customer Satisfaction))

S --> R

R --> C

MS -.-> S

MP -.-> S

AD -.-> S

CP -.-> S

RD --> PQ

PQ -.-> CS

CS -.-> S

end

```

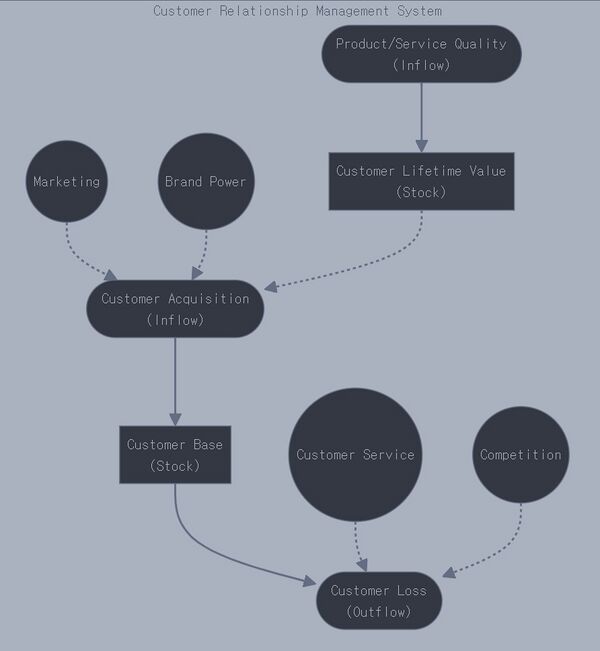

2. 고객 관계 관리(CRM) 모델:

```mermaid flowchart LR

subgraph "Customer Relationship Management System"

CB["Customer Base

(Stock)"]

CA(["Customer Acquisition

(Inflow)"])

CL(["Customer Loss

(Outflow)"])

MK((Marketing))

CS((Customer Service))

BP((Brand Power))

CP((Competition))

CLV["Customer Lifetime Value

(Stock)"]

PS(["Product/Service Quality

(Inflow)"])

CA --> CB

CB --> CL

MK -.-> CA

CS -.-> CL

BP -.-> CA

CP -.-> CL

PS --> CLV

CLV -.-> CA

end

```

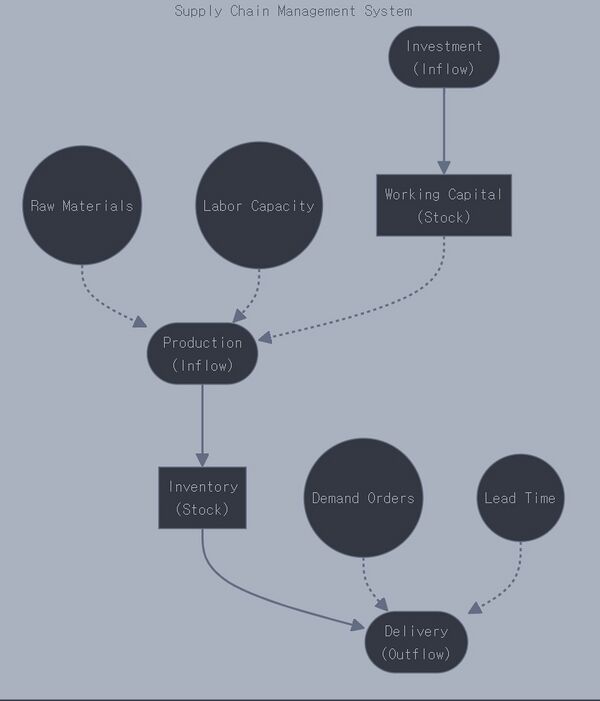

3. 공급망 관리 모델:

```mermaid flowchart LR

subgraph "Supply Chain Management System"

I["Inventory

(Stock)"]

P(["Production

(Inflow)"])

D(["Delivery

(Outflow)"])

RM((Raw Materials))

LC((Labor Capacity))

DO((Demand Orders))

LT((Lead Time))

WC["Working Capital

(Stock)"]

IC(["Investment

(Inflow)"])

P --> I

I --> D

RM -.-> P

LC -.-> P

DO -.-> D

LT -.-> D

IC --> WC

WC -.-> P

end

```

이러한 SFD 모델들의 활용 방법:

1. 제품 수명주기 및 매출 예측 모델 - 주요 활용:

* 신제품 출시 전략 수립 * 마케팅 예산 할당 * R&D 투자 시점 결정 * 수익성 예측

2. CRM 모델 - 주요 활용:

* 고객 확보 전략 수립 * 고객 이탈 방지 정책 * 마케팅 효과성 측정 * 고객 생애 가치 예측

3. 공급망 관리 모델 - 주요 활용:

* 재고 수준 최적화 * 생산 계획 수립 * 리드타임 관리 * 운전자본 필요액 예측

각 모델의 실제 구현 시 고려사항:

1. 데이터 요구사항 - 과거 실적 데이터 - 시장 환경 데이터 - 경쟁사 정보 - 고객 피드백

2. 모델 검증 - 과거 데이터로 시뮬레이션 - 민감도 분석 - 시나리오 테스트

3. 운영 적용 - 정기적인 모니터링 - 예측치와 실제값 비교 - 필요시 모델 조정

4. 의사결정 연계 - 전략 계획 수립 - 예산 배분 - 리스크 관리 - 성과 평가

이러한 SFD 모델들은 비즈니스의 동태적 특성을 이해하고 예측하는데 매우 유용한 도구가 됩니다.

R을 활용한 비즈니스 분석의 주요 예제를 한글로 설명해드리겠습니다.

```r

- 필요한 라이브러리 불러오기

library(tidyverse) library(forecast) library(ggplot2) library(lubridate)

- 1. 매출 분석 및 예측

- 샘플 매출 데이터 생성

매출_데이터 <- data.frame(

날짜 = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"),

매출액 = runif(365, 1000, 5000) + sin(1:365/30)*1000

)

- 시계열 분석

매출_시계열 <- ts(매출_데이터$매출액, frequency = 7) 매출_예측 <- forecast(auto.arima(매출_시계열), h = 30)

- 매출 예측 그래프

매출_그래프 <- ggplot() +

geom_line(data = 매출_데이터, aes(x = 날짜, y = 매출액)) +

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30),

y = 매출_예측$mean), color = "blue") +

labs(title = "매출 예측", x = "날짜", y = "매출액")

- 2. 고객 세분화

- 샘플 고객 데이터 생성

set.seed(123) 고객_데이터 <- data.frame(

고객ID = 1:1000, 최근성 = sample(1:365, 1000, replace = TRUE), 구매빈도 = rpois(1000, 5), 구매금액 = rlnorm(1000, meanlog = 5)

)

- K-means 클러스터링 수행

군집분석 <- kmeans(scale(고객_데이터[, c("최근성", "구매빈도", "구매금액")]), centers = 4) 고객_데이터$세그먼트 <- as.factor(군집분석$cluster)

- 세그먼트 시각화

세그먼트_그래프 <- ggplot(고객_데이터, aes(x = 구매빈도, y = 구매금액, color = 세그먼트)) +

geom_point() + labs(title = "고객 세그먼트", x = "구매 빈도", y = "총 구매액")

- 3. 코호트 분석

- 샘플 코호트 데이터 생성

코호트_데이터 <- data.frame(

가입일 = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE),

고객ID = 1:1000,

매출액 = rlnorm(1000, meanlog = 4)

)

- 코호트 지표 계산

코호트_분석 <- 코호트_데이터 %>%

mutate(코호트 = format(가입일, "%Y-%m")) %>% group_by(코호트) %>% summarise( 고객수 = n(), 총매출 = sum(매출액), 평균매출 = mean(매출액) )

- 4. 이탈 예측

- 샘플 고객 이탈 데이터 생성

이탈_데이터 <- data.frame(

고객ID = 1:1000,

고객기간 = sample(1:60, 1000, replace = TRUE),

월이용료 = runif(1000, 30, 100),

총이용금액 = runif(1000, 1000, 5000),

이탈여부 = sample(c("이탈", "유지"), 1000, replace = TRUE, prob = c(0.2, 0.8))

)

- 로지스틱 회귀 모델 적용

이탈_모델 <- glm(이탈여부 ~ 고객기간 + 월이용료 + 총이용금액,

data = 이탈_데이터,

family = "binomial")

- 비즈니스 리포트 생성 함수

비즈니스_리포트_생성 <- function(데이터) {

요약_통계 <- list( 총고객수 = nrow(데이터), 평균매출 = mean(데이터$총이용금액), 이탈율 = mean(데이터$이탈여부 == "이탈"), 우수고객수 = sum(데이터$총이용금액 > mean(데이터$총이용금액)) ) return(요약_통계)

}

- 데이터 시각화 함수

비즈니스_대시보드_생성 <- function(데이터) {

# 매출 트렌드 매출_그래프 <- ggplot(데이터, aes(x = 고객기간, y = 총이용금액)) + geom_point() + geom_smooth() + labs(title = "고객 기간별 매출 현황") # 이탈 분포 이탈_그래프 <- ggplot(데이터, aes(x = 이탈여부, fill = 이탈여부)) + geom_bar() + labs(title = "이탈 고객 분포") return(list(매출_그래프 = 매출_그래프, 이탈_그래프 = 이탈_그래프))

}

```

이 R 코드는 다음과 같은 주요 비즈니스 분석 기법을 포함하고 있습니다:

1. 매출 분석 및 예측 - ARIMA를 이용한 시계열 분석 - 매출 트렌드 시각화 - 미래 매출 예측

2. 고객 세분화 분석 - K-means 클러스터링 - RFM(최근성, 구매빈도, 구매금액) 분석 - 세그먼트 시각화

3. 코호트 분석 - 가입 시점별 고객 그룹화 - 코호트별 매출 지표 - 고객 유지율 분석

4. 고객 이탈 예측 - 로지스틱 회귀 모델링 - 위험 요인 분석 - 고객 유지 인사이트 도출

코드에 포함된 주요 기능: - 데이터 준비 및 전처리 - 통계 분석 - 데이터 시각화 - 모델 구축 - 리포트 생성

# 필요한 라이브러리 불러오기

library(tidyverse)

library(forecast)

library(ggplot2)

library(lubridate)

# 1. 매출 분석 및 예측

# 샘플 매출 데이터 생성

매출_데이터 <- data.frame(

날짜 = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"),

매출액 = runif(365, 1000, 5000) + sin(1:365/30)*1000

)

# 시계열 분석

매출_시계열 <- ts(매출_데이터$매출액, frequency = 7)

매출_예측 <- forecast(auto.arima(매출_시계열), h = 30)

# 매출 예측 그래프

매출_그래프 <- ggplot() +

geom_line(data = 매출_데이터, aes(x = 날짜, y = 매출액)) +

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30),

y = 매출_예측$mean), color = "blue") +

labs(title = "매출 예측", x = "날짜", y = "매출액")

# 2. 고객 세분화

# 샘플 고객 데이터 생성

set.seed(123)

고객_데이터 <- data.frame(

고객ID = 1:1000,

최근성 = sample(1:365, 1000, replace = TRUE),

구매빈도 = rpois(1000, 5),

구매금액 = rlnorm(1000, meanlog = 5)

)

# K-means 클러스터링 수행

군집분석 <- kmeans(scale(고객_데이터[, c("최근성", "구매빈도", "구매금액")]), centers = 4)

고객_데이터$세그먼트 <- as.factor(군집분석$cluster)

# 세그먼트 시각화

세그먼트_그래프 <- ggplot(고객_데이터, aes(x = 구매빈도, y = 구매금액, color = 세그먼트)) +

geom_point() +

labs(title = "고객 세그먼트", x = "구매 빈도", y = "총 구매액")

# 3. 코호트 분석

# 샘플 코호트 데이터 생성

코호트_데이터 <- data.frame(

가입일 = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE),

고객ID = 1:1000,

매출액 = rlnorm(1000, meanlog = 4)

)

# 코호트 지표 계산

코호트_분석 <- 코호트_데이터 %>%

mutate(코호트 = format(가입일, "%Y-%m")) %>%

group_by(코호트) %>%

summarise(

고객수 = n(),

총매출 = sum(매출액),

평균매출 = mean(매출액)

)

# 4. 이탈 예측

# 샘플 고객 이탈 데이터 생성

이탈_데이터 <- data.frame(

고객ID = 1:1000,

고객기간 = sample(1:60, 1000, replace = TRUE),

월이용료 = runif(1000, 30, 100),

총이용금액 = runif(1000, 1000, 5000),

이탈여부 = sample(c("이탈", "유지"), 1000, replace = TRUE, prob = c(0.2, 0.8))

)

# 로지스틱 회귀 모델 적용

이탈_모델 <- glm(이탈여부 ~ 고객기간 + 월이용료 + 총이용금액,

data = 이탈_데이터,

family = "binomial")

# 비즈니스 리포트 생성 함수

비즈니스_리포트_생성 <- function(데이터) {

요약_통계 <- list(

총고객수 = nrow(데이터),

평균매출 = mean(데이터$총이용금액),

이탈율 = mean(데이터$이탈여부 == "이탈"),

우수고객수 = sum(데이터$총이용금액 > mean(데이터$총이용금액))

)

return(요약_통계)

}

# 데이터 시각화 함수

비즈니스_대시보드_생성 <- function(데이터) {

# 매출 트렌드

매출_그래프 <- ggplot(데이터, aes(x = 고객기간, y = 총이용금액)) +

geom_point() +

geom_smooth() +

labs(title = "고객 기간별 매출 현황")

# 이탈 분포

이탈_그래프 <- ggplot(데이터, aes(x = 이탈여부, fill = 이탈여부)) +

geom_bar() +

labs(title = "이탈 고객 분포")

return(list(매출_그래프 = 매출_그래프, 이탈_그래프 = 이탈_그래프))

}

동일 코드 영문

# Load required libraries

library(tidyverse)

library(forecast)

library(ggplot2)

library(lubridate)

# 1. Sales Analysis and Forecasting

# Create sample sales data

sales_data <- data.frame(

date = seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "day"),

sales = runif(365, 1000, 5000) + sin(1:365/30)*1000

)

# Time series analysis

sales_ts <- ts(sales_data$sales, frequency = 7)

sales_forecast <- forecast(auto.arima(sales_ts), h = 30)

# Plot sales forecast

plot_forecast <- ggplot() +

geom_line(data = sales_data, aes(x = date, y = sales)) +

geom_line(aes(x = seq(as.Date("2024-01-01"), by = "day", length.out = 30),

y = sales_forecast$mean), color = "blue") +

labs(title = "Sales Forecast", x = "Date", y = "Sales")

# 2. Customer Segmentation

# Create sample customer data

set.seed(123)

customer_data <- data.frame(

customer_id = 1:1000,

recency = sample(1:365, 1000, replace = TRUE),

frequency = rpois(1000, 5),

monetary = rlnorm(1000, meanlog = 5)

)

# Perform k-means clustering

kmeans_result <- kmeans(scale(customer_data[, c("recency", "frequency", "monetary")]), centers = 4)

customer_data$segment <- as.factor(kmeans_result$cluster)

# Visualize segments

segment_plot <- ggplot(customer_data, aes(x = frequency, y = monetary, color = segment)) +

geom_point() +

labs(title = "Customer Segments", x = "Purchase Frequency", y = "Total Spend")

# 3. Cohort Analysis

# Create sample cohort data

cohort_data <- data.frame(

join_date = sample(seq(as.Date("2023-01-01"), as.Date("2023-12-31"), by = "month"), 1000, replace = TRUE),

customer_id = 1:1000,

revenue = rlnorm(1000, meanlog = 4)

)

# Calculate cohort metrics

cohort_analysis <- cohort_data %>%

mutate(cohort = format(join_date, "%Y-%m")) %>%

group_by(cohort) %>%

summarise(

customers = n(),

total_revenue = sum(revenue),

avg_revenue = mean(revenue)

)

# 4. Market Basket Analysis

library(arules)

# Create sample transaction data

transaction_data <- data.frame(

transaction_id = rep(1:500, each = 3),

product = sample(c("A", "B", "C", "D", "E"), 1500, replace = TRUE)

)

# Convert to transactions format

transactions <- split(transaction_data$product, transaction_data$transaction_id)

transactions <- as(transactions, "transactions")

# Find frequent itemsets

frequent_items <- apriori(transactions,

parameter = list(support = 0.01, confidence = 0.5))

# 5. Churn Prediction

# Create sample customer churn data

churn_data <- data.frame(

customer_id = 1:1000,

tenure = sample(1:60, 1000, replace = TRUE),

monthly_charges = runif(1000, 30, 100),

total_charges = runif(1000, 1000, 5000),

churn = sample(c("Yes", "No"), 1000, replace = TRUE, prob = c(0.2, 0.8))

)

# Fit logistic regression model

churn_model <- glm(churn ~ tenure + monthly_charges + total_charges,

data = churn_data,

family = "binomial")

# Function to generate summary report

generate_business_report <- function(data) {

summary_stats <- list(

total_customers = nrow(data),

average_revenue = mean(data$total_charges),

churn_rate = mean(data$churn == "Yes"),

high_value_customers = sum(data$total_charges > mean(data$total_charges))

)

return(summary_stats)

}

# Example of data visualization function

create_business_dashboard <- function(data) {

# Revenue trend

revenue_plot <- ggplot(data, aes(x = tenure, y = total_charges)) +

geom_point() +

geom_smooth() +

labs(title = "Revenue by Customer Tenure")

# Churn distribution

churn_plot <- ggplot(data, aes(x = churn, fill = churn)) +

geom_bar() +

labs(title = "Churn Distribution")

return(list(revenue_plot = revenue_plot, churn_plot = churn_plot))

}

확보할 수 있는 데이터 형태로 분석 방법이 개발된 듯

기존 참고하고자 하는 데이터 기준, 추가 환경 데이터, 제품 데이터, 판매 데이터 등을 추정하여 만듬

AI 분석은 요약 데이터를 활용하는 것이 좋으며 (R에서 판매량 데이터를 단순 사인데이터로 만듬)

모든 데이터를 넣어서 처리하는 것은 머신러닝 혹은 빅데이터 처리 프로세스를 그대로 따르는 것이 좋음

결론:

- 데이터 취득 전략 - 기존 데이터를 변경하거나, 데이터 처리에 있어, 필요한 데이터 기준 선별, 지속 데이터 취득

- 다른 요소는 이에 맞춰 취합 - 영향을 주는 요소들 경험 및 실제 데이터를 기준으로 반영 (이전 데이터 시점과 해당일 선행 이슈 파악?)

- 해석 방법을 염두에 둔 데이터 모델 추정